AI数据中心推动MPO互连需求

AI 集群需要超高速 GPU 互连,推动了 MPO 光缆在高性能计算中的采用。MPO 支持并行光学和大型光纤数量,确保了训练大型 AI 模型和支持下一代人工智能工作负载所需的低延迟、高带宽连接。

2025-03

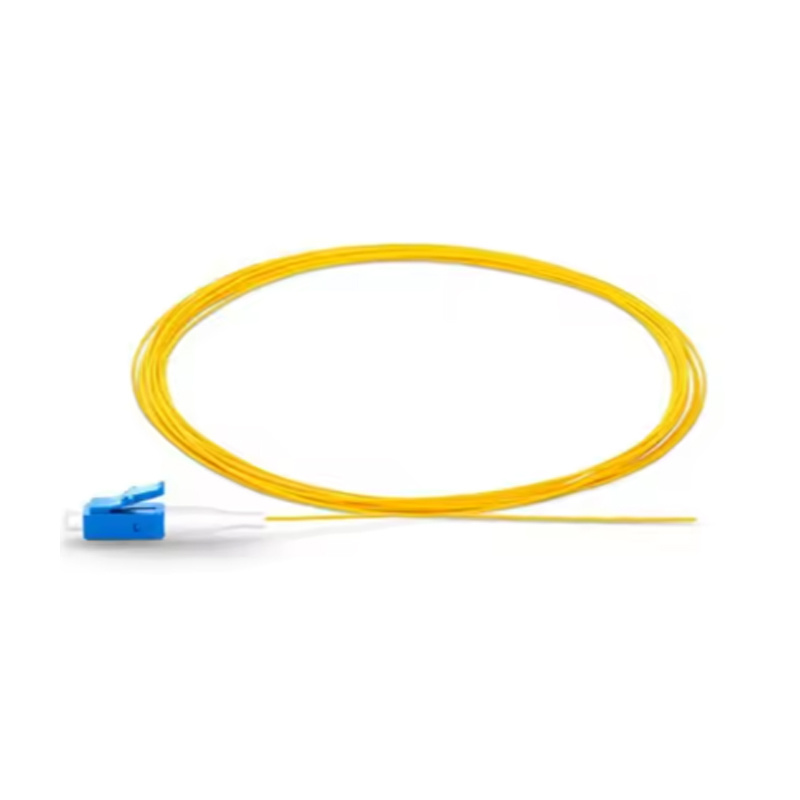

人工智能 (AI) 计算持续重塑着科技格局,对数据中心高速、低延迟互连的需求也呈爆炸式增长。深度学习训练和大型语言模型 (LLM) 等 AI 工作负载需要海量的 GPU 到 GPU 通信,数据传输速度达到每秒太比特。在此背景下,MPO(多光纤推入式)连接器正在成为一项至关重要的基础设施解决方案。

MPO 和 AI 集群互连

AI 计算集群通常使用数百或数千个 GPU,这些 GPU 通过多个机架互连。这些 GPU 实时交换大量数据,使得光纤互连成为必需。MPO 布线凭借其对并行传输和高光纤数量的支持,非常适合此类应用。

例如,NVIDIA DGX 或 AMD Instinct 平台通常依赖于具有 16 光纤 MPO 连接器的 800G 收发器,以在计算节点之间建立快速、低延迟的链路。

MPO 在 AI 工作负载中的优势

-

高密度连接减少了布线混乱并节省了空间

-

并行光学器件支持同时进行多通道数据传输

-

工厂预先制作的 MPO组件确保一致的性能

-

支持热插拔升级和模块化基础设施

与传统的铜缆或双工 LC 光纤链路不同,MPO 支持 AI 基础设施的大规模数据需求,而不会影响气流或可靠性。

为未来做准备

随着 AI 模型的持续扩展——从数十亿到数万亿个参数——对可扩展、高效的光学互连的需求只会越来越大。MPO 提供了一种面向未来的解决方案,数据中心可以立即部署该解决方案,以应对 AI 的爆炸式增长。

上一个:

下一个:

相关新闻

COOKIES

我们的网站使用 cookie 和类似技术来个性化向您展示的广告,并帮助您在我们的网站上获得最佳体验。 欲了解更多信息,请参阅我们的隐私和 Cookie 政策

COOKIES

我们的网站使用 cookie 和类似技术来个性化向您展示的广告,并帮助您在我们的网站上获得最佳体验。 欲了解更多信息,请参阅我们的隐私和 Cookie 政策

这些 cookie 是支付等基本功能所必需的。 标准 cookie 无法关闭,也不会存储您的任何信息。

这些 cookie 收集信息,例如有多少人正在使用我们的网站或哪些页面受欢迎,以帮助我们改善客户体验。 关闭这些 cookie 将意味着我们无法收集信息来改善体验。

这些 cookie 使网站能够提供增强的功能和个性化。 它们可能由我们或我们已将其服务添加到我们页面的第三方提供商设置。 如果您不允许这些 cookie,那么部分或全部这些服务可能无法正常运行。

这些 cookie 帮助我们了解您感兴趣的内容,以便我们可以在其他网站上向您展示相关广告。 关闭这些 cookie 将意味着我们无法向您展示任何个性化广告。